반응형

SGD 관련 이슈는 하이퍼파라미터를 어떻게 설정할지에 관한 것이다.

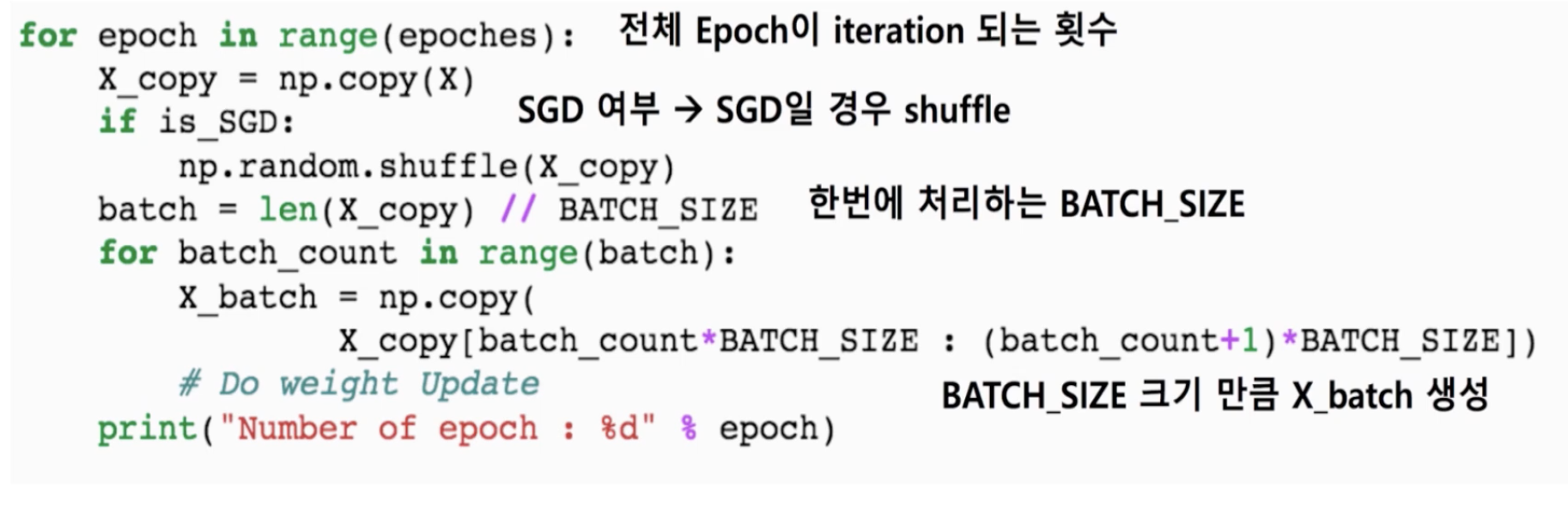

먼저 수도 코드로 SGD 라인의 개념 네가지를 이해해보도록 하자.

GD, BGD, SGD, MSGD

수도 코드

네 가지 개념

Gradient Descent

Batch Gradient Descent

Stochastic Gradient Descent

Mini-batch Gradient Descent

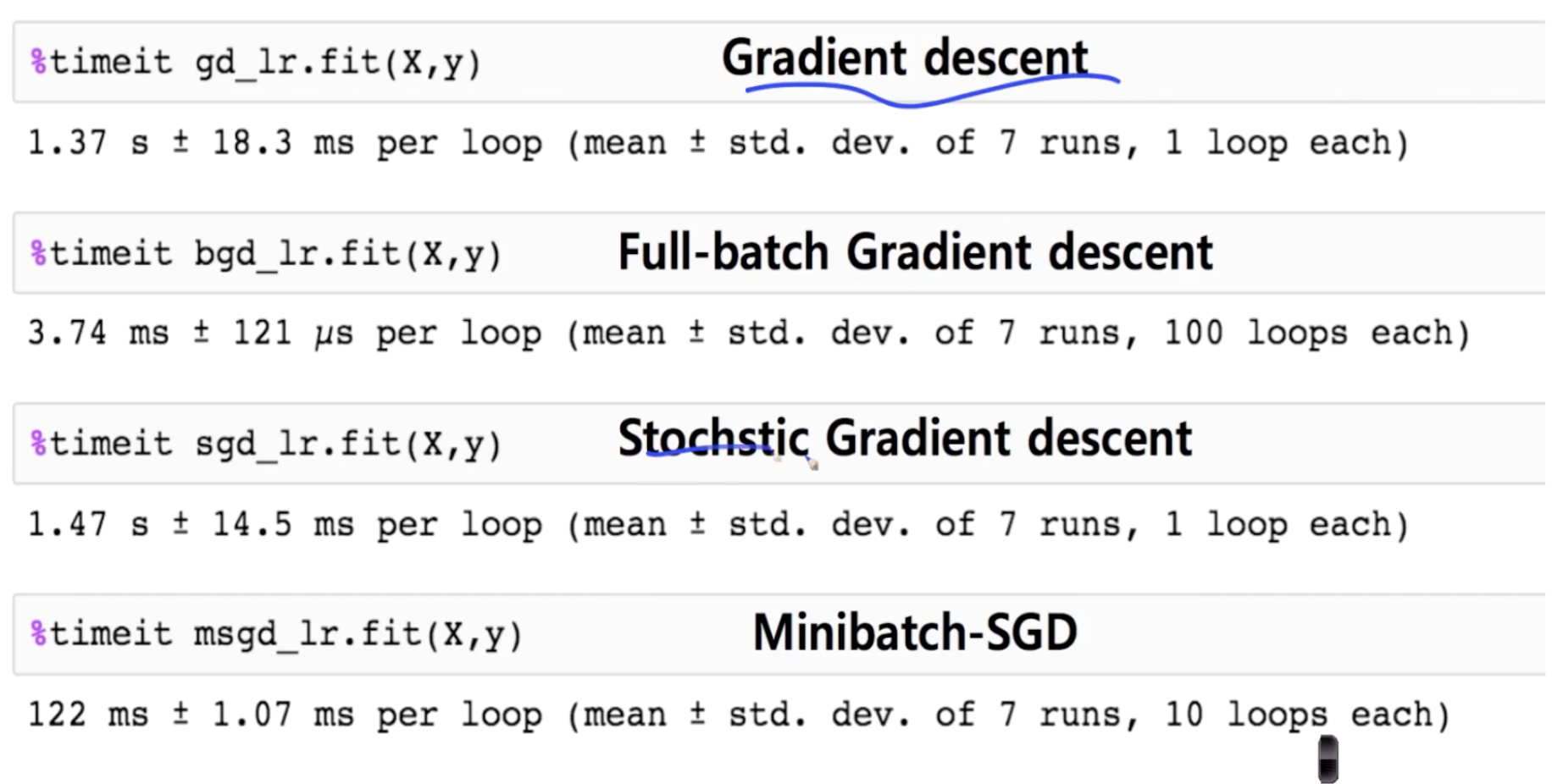

Time Consuming

한 개 씩 처리하는 GD와 SGD의 속도가 배치 단위로 처리하는 BGD, MSGD보다 빠르다.

Convergence Process

빨강 - GD

노랑 - BGD

파랑 - MSGD : 랜덤하게 값을 주기 때문에 값이 튄다.

초록 - SGD

Multivariate

데이터가 적을 때 - normal equation

데이터가 많을 때 - SGD

Learning Rate

Learning Rate가 계속 줄어야 효율적으로 학습할 수 있다.

1) 특정 epocha 마다 사람이 learning rate를 설정해주는 것

2) 지수감소법, 1/t 감소법을 사용

종료조건 설정

1) 특정값 이하로 cost function이 줄어들지 않는 경우 GD를 멈춘다

2) 사람이 종료 조건을 설정한다(하이퍼 파라미터)

tol > loss - previous_loss

반응형

'AI > Machine Learning' 카테고리의 다른 글

| Regularization (0) | 2021.01.27 |

|---|---|

| Overfitting (0) | 2021.01.27 |

| Stochastic Gradient Descent (0) | 2021.01.26 |

| Holdout method (0) | 2021.01.26 |

| Gradient Descent (0) | 2021.01.26 |