다음은 Apple의 Vision OS 사용에 대한 칼럼으로, 최근에 소개된 장치인 Vision Pro와 MR(Mixed Reality) 헤드셋과의 호환성에 대한 정보를 포함합니다

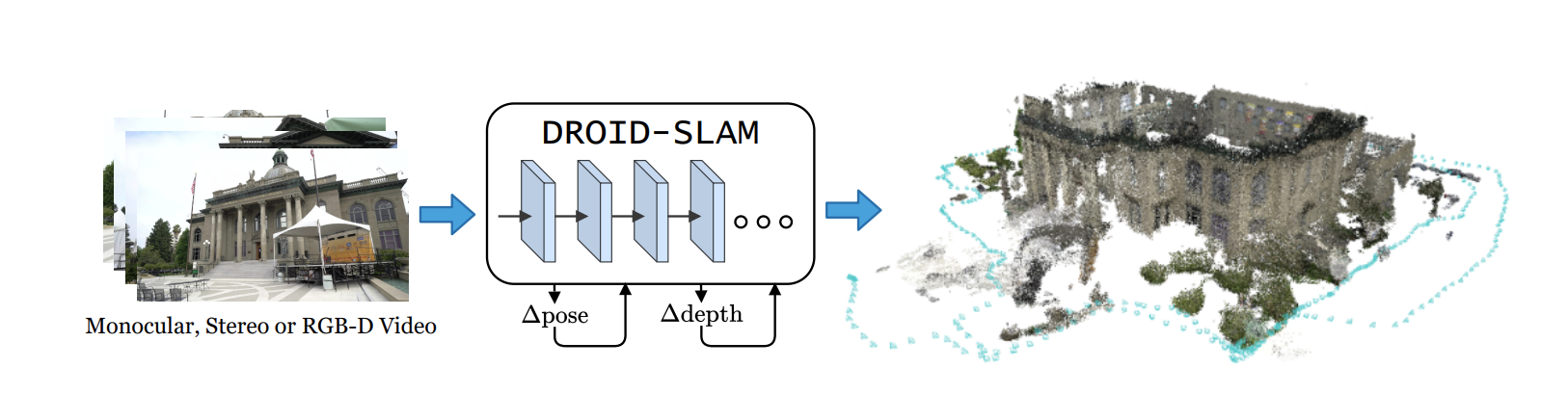

끊임없이 진화하는 기술 환경에서 애플은 개발자와 사용자에게 몰입형 경험을 만들 수 있는 획기적인 도구를 제공하면서 혁신의 경계를 계속해서 밀어붙이고 있습니다. 그러한 도구 중 하나는 개발자들이 컴퓨터 비전과 기계 학습의 힘을 활용할 수 있도록 지원하는 강력한 플랫폼인 애플의 비전 OS이다. 오늘은 비전 OS의 세계와 그 놀라운 잠재력을 탐구하는 동시에 애플이 최근 선보인 기기인 비전 프로와 MR(Mixed Reality) 헤드셋과의 원활한 통합에 대해 자세히 알아본다.

Vision Pro: 증강현실의 미래를 재정의합니다

Apple의 Vision Pro는 증강 현실 기능의 상당한 도약을 나타냅니다. 이 최첨단 장치는 최첨단 하드웨어와 고급 비전 OS를 결합하여 비길 데 없는 증강 현실 경험을 제공합니다. 날렵하고 가벼운 디자인의 Vision Pro는 디지털 세계와 상호 작용할 수 있는 편안하고 몰입적인 방법을 사용자에게 제공합니다. 강력한 센서, 카메라 및 고해상도 디스플레이를 갖춘 Vision Pro는 개발자들이 가상 콘텐츠를 실제 세계와 원활하게 혼합하는 놀라운 AR 애플리케이션을 만들 수 있도록 지원합니다.

MR 헤드셋으로 새로운 영역 잠금 해제

비전 프로의 뛰어난 기능을 보완하기 위해 애플은 MR 헤드셋의 잠재력을 수용했다. 이러한 헤드셋은 사용자에게 가상 세계와 물리적 세계 사이의 선을 흐리게 하면서 진정으로 몰입할 수 있는 혼합 현실 경험을 제공한다. 개발자는 Vision OS SDK와 강력한 컴퓨터 비전 알고리즘을 활용하여 사용자 환경에 실시간으로 대응하는 MR 애플리케이션을 만들 수 있습니다. 생산성 향상, 게임 경험 혁신, 커뮤니케이션 혁신 등 다양한 분야에서 Vision Pro와 MR 헤드셋의 결합은 다양한 가능성을 열어줍니다.

개념에서 현실로: Vision OS SDK 활용

이러한 발견과 혁신의 여정을 시작하기 위해 개발자는 컴퓨터 비전 기능을 애플리케이션에 완벽하게 통합할 수 있는 포괄적인 툴킷인 Vision OS SDK에 뛰어들 수 있습니다. 개발자는 강력한 API, 사전 교육된 모델 및 광범위한 설명서에 액세스하여 Vision OS의 강력한 기능을 활용하는 애플리케이션을 신속하게 프로토타입화하고 구축할 수 있습니다. Vision OS SDK는 객체 인식 및 추적에서 얼굴 분석 및 제스처 감지에 이르기까지 개발자에게 매력적이고 몰입적인 경험을 제공하는 도구를 제공합니다.

결론:

애플이 기술의 경계를 계속 밀어붙이면서 비전 OS 플랫폼은 우리가 디지털 세계와 상호 작용하는 방식에 혁명을 일으키는 최전선에 서 있다. 비전 프로의 도입과 MR 헤드셋과의 호환성으로 몰입적이고 혁신적인 경험을 만들 수 있는 가능성은 무한하다. Vision OS의 힘과 그것이 제공하는 도구를 활용함으로써, 개발자들은 증강 현실의 진정한 잠재력을 열 수 있으며, 일상적인 작업을 더 직관적이고, 재미있고, 특별하게 만들 수 있다.

이번 소개에서는 비전 프로 기기의 중요성과 MR 헤드셋과의 통합을 강조하며 애플 비전 OS의 기능을 탐구하는 무대를 마련한다. 필기 스타일 및 특정 초점 영역에 맞게 자유롭게 수정하고 조정할 수 있습니다.

'Programming' 카테고리의 다른 글

| Apple Vision OS SDK 다운로드 및 초기세팅 방법 (0) | 2023.06.28 |

|---|---|

| 안드로이드 생명주기 (LifeCycle) (0) | 2021.11.29 |