Supervised Learning

1) classification( Yes or No )

: 실제 범주와 예측한 범주의 일치하는 정도

2) regression

: 실제값과 예측한 값의 차이(=오차)를 통해 모델의 성능 평가

Unsupervised Learning

1) Clustering

'AI > Machine Learning' 카테고리의 다른 글

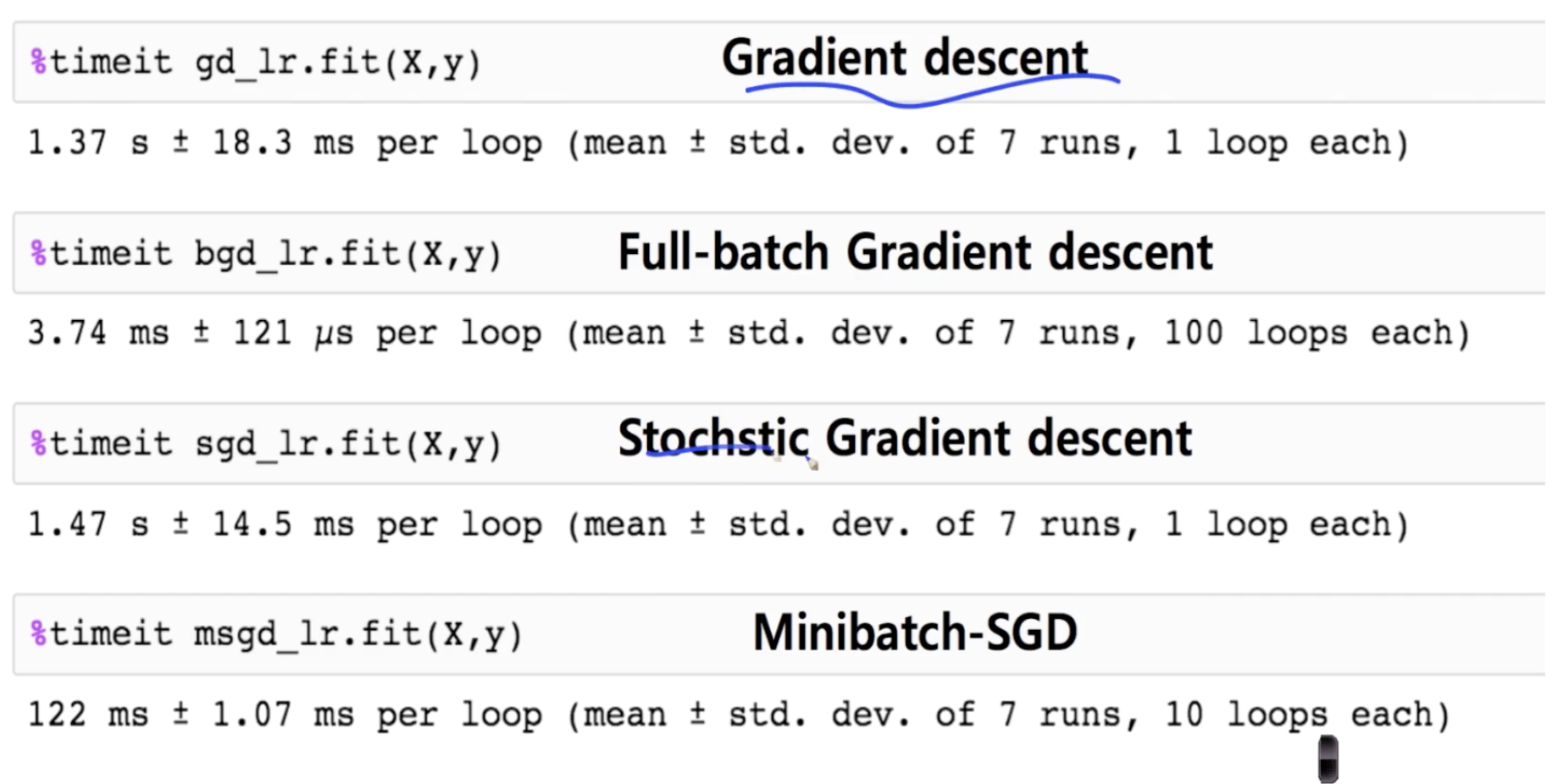

| Regression (0) | 2021.02.02 |

|---|---|

| Confusion Matrix (0) | 2021.02.02 |

| Data preprocessing & Feature engineering (0) | 2021.02.01 |

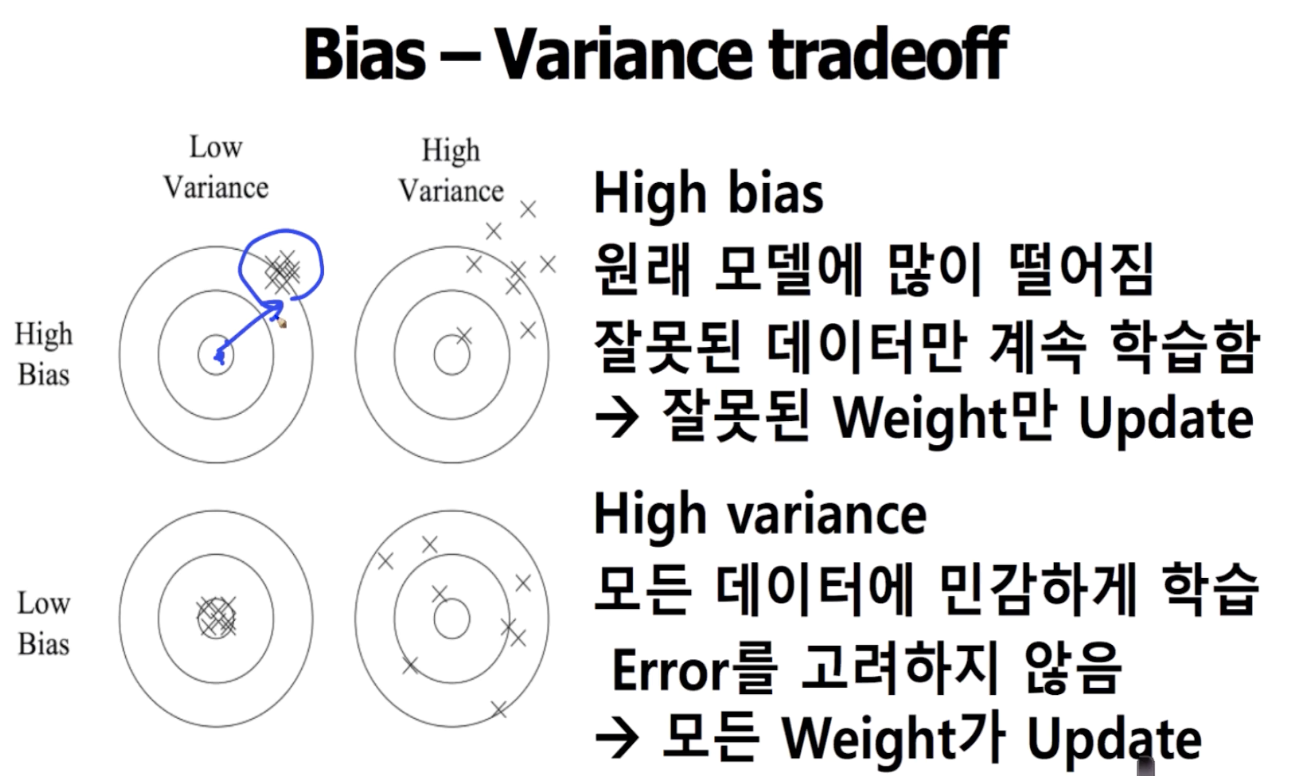

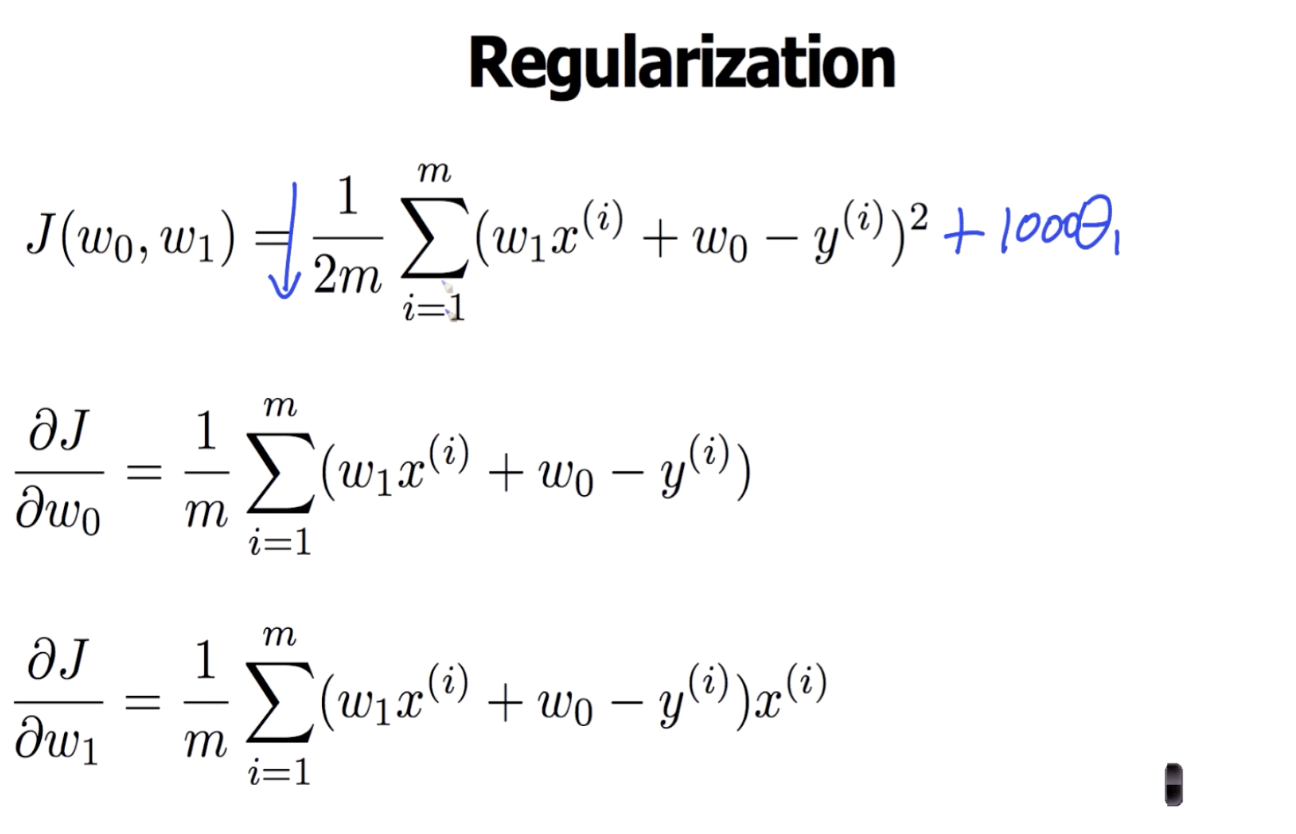

| Regularization (0) | 2021.01.27 |

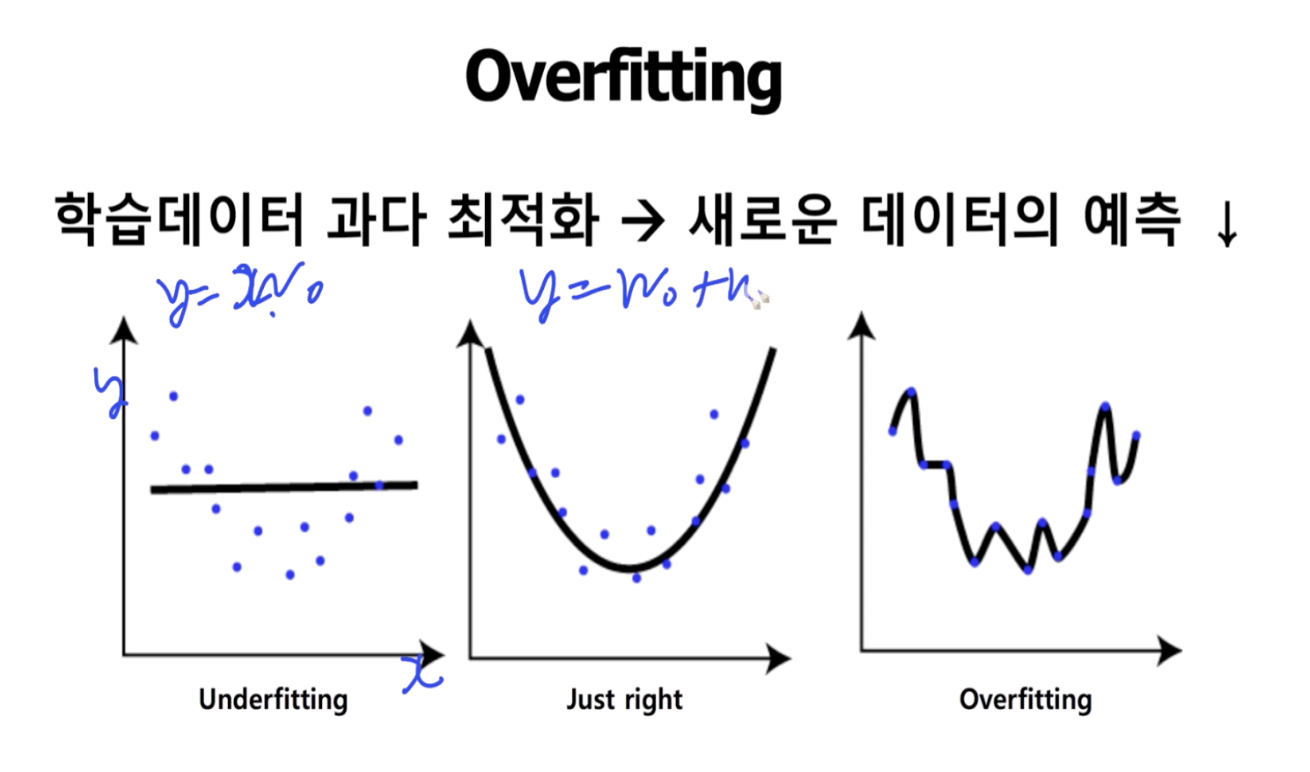

| Overfitting (0) | 2021.01.27 |